更新时间:2025-03-11 10:40:33

字节跳动旗下的豆包大模型团队开源优化技术,令其训练成本节约四成。上述团队宣布开源混合专家模型(MoE)架构的关键优化技术。此技术通过一系列创新方法,将大模型的训练效率提升约1.7倍,同时也将训练成本降低40%。

这一技术已在字节跳动的万卡集群训练中得到实际应用。内部数据显示,自采用该技术以来,已累计节省了数百万GPU(图形处理器)小时的训练算力。

豆包大模型团队决定开源此技术,是希望通过分享这一技术,推动整个人工智能(AI)社区在模型训练效率方面的共同进步。开源不仅有助于加速行业技术发展,还能为更多研究者和开发者提供宝贵的资源,进一步推动AI技术的创新与应用。

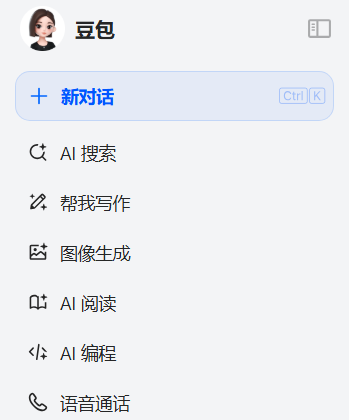

字节跳动推出的豆包大模型,成为中国市场上最受欢迎的AI聊天机器人。

专题:豆包